随着数据量的爆炸式增长和技术架构的持续演进,大数据的发展已迈过早期的数据收集、存储与基础分析阶段。如今,业界共识正指向一个更为集成和智能化的方向:服务与分析一体化的数据处理服务。这不仅是技术的自然延伸,更是业务需求驱动的必然趋势,它标志着大数据从“洞察工具”向“价值引擎”的深刻转变。

一、何为“服务与分析一体化”?

传统的大数据架构中,数据处理通常遵循一条线性管道:数据采集 → 数据存储(如数据湖/仓)→ 数据处理与清洗 → 数据分析与建模 → 结果可视化或报告。这条链条虽然清晰,但环节割裂,分析结果与应用服务之间存在“最后一公里”的鸿沟。业务部门获取洞察后,仍需投入大量工程化工作才能将其转化为可运行的应用程序或自动化决策服务。

“服务与分析一体化”旨在彻底打破这种隔阂。它意味着将数据处理、深度分析与实时服务能力无缝融合在一个统一的平台或框架内。其核心特征是:

- 闭环智能:分析模型能够直接驱动业务服务,服务产生的反馈数据又能实时回流,用于模型的优化与迭代,形成一个自我增强的闭环。

- 实时化与操作化:分析不再局限于离线的、面向历史的报表,而是能够支持低延迟的实时决策,并直接嵌入到业务流程中(例如,实时风控、个性化推荐、智能运维)。

- 服务化接口:复杂的数据处理与分析能力被封装成标准的、可调用的API或微服务,业务开发人员可以像调用普通服务一样,便捷地获取数据智能,而无需深究底层复杂的分布式计算细节。

- 统一治理与安全:在数据流动、处理、服务化的全链条中,实施统一的元数据管理、数据质量监控、访问权限控制和安全合规保障。

二、驱动一体化趋势的核心力量

- 业务需求从“描述过去”到“预测与行动”:企业不再满足于知道“发生了什么”,更迫切地需要知道“将要发生什么”以及“现在该如何行动”。这要求数据分析必须与业务动作紧密结合。

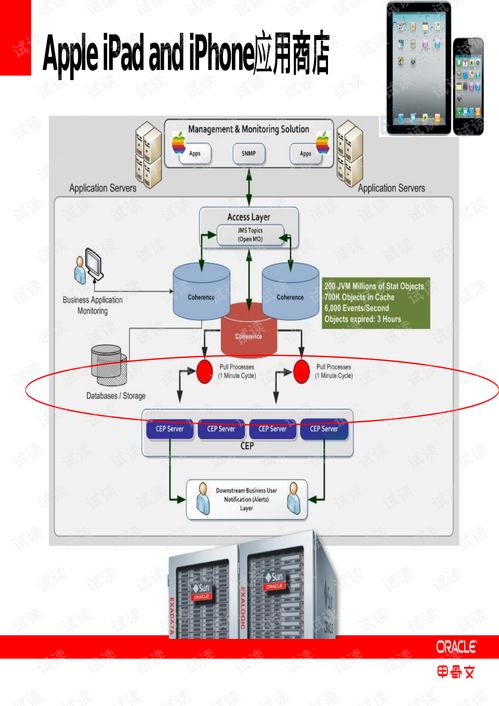

- 技术栈的融合与成熟:云原生、容器化、微服务架构的普及,为灵活部署和编排数据服务提供了基础。流处理技术(如Apache Flink)、机器学习平台(MLOps)、服务网格(Service Mesh)的成熟,使得实时分析模型的生产化部署与管理变得可行。

- 成本与效率的考量:割裂的架构导致数据在多个系统间复制、迁移,产生冗余计算和存储成本,且开发运维复杂。一体化平台通过统一资源调度和简化架构,能够显著提升资源利用率和开发运维效率。

- 数据平民化的深化:为了让业务专家、分析师等非技术角色也能直接利用数据能力,必须将分析逻辑产品化为易用的服务,降低使用门槛。

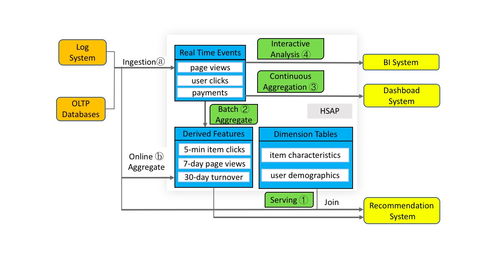

三、一体化数据处理服务的典型架构与场景

一个现代化的一体化数据处理平台可能呈现以下层次:

- 统一数据层:融合数据湖的灵活性与数据仓库的性能,支持多模态数据(结构化、半结构化、非结构化)的统一存储与管理。

- 智能计算层:集成批处理、流处理、交互式查询和图计算等多种计算范式,并内置机器学习框架与模型仓库,支持从训练到推理的全流程。

- 服务化与API层:将数据处理流水线(ETL/ELT)、分析模型、查询结果等封装为RESTful API、GraphQL或事件流,供前端应用、业务系统或其他服务调用。

- 运营与治理层:提供端到端的数据血缘、质量监控、成本分析和统一的安全策略管理。

应用场景示例:

- 金融实时风控:流处理引擎实时分析交易流水,风控模型即时评分,一旦发现可疑交易,风控服务API即刻被调用,触发拦截或人工审核流程,整个过程在毫秒级完成。

- 电商个性化营销:用户行为数据实时流入,推荐模型在线更新用户画像,商品推荐服务API根据当前场景(首页、商品页、购物车)实时返回个性化列表,直接提升转化率。

- 工业物联网预测性维护:设备传感器数据流被持续分析,异常检测模型识别潜在故障模式,维护服务自动生成工单并派发至维修人员,实现从感知到行动的自动化。

四、面临的挑战与未来展望

迈向服务与分析一体化的道路并非坦途,企业需应对诸多挑战:

- 技术复杂性:整合多种技术栈并保证高性能、高可用性是一项巨大的工程挑战。

- 组织与文化壁垒:需要打破数据团队、分析团队与业务开发团队之间的隔阂,向“数据产品团队”模式转型。

- 安全与治理:数据服务化后,访问点增多,数据安全和隐私保护的挑战加剧。

- 成本控制:实时服务与分析通常消耗更多计算资源,需要精细化的成本优化策略。

大数据的下一站将是一个以“数据即服务”为核心,智能无处不在的生态。人工智能与机器学习将更深地嵌入一体化流程,实现更高级的自动决策。边缘计算将与云端一体化平台协同,满足更低延迟和隐私敏感场景的需求。成功的企业将是那些能够将数据洞察无缝、实时地转化为业务行动,并形成持续优化闭环的组织。服务与分析一体化,正是通往这一未来的关键路径。